网堵新闻网8月23日电 分布式机器学习能够协同实际系统中分布在不同节点的数据和资源,通过节点间共享学习中间变量(如模型参数)进行模型训练。该技术具有去中心化的特性,一定程度上避免了数据集中存储带来的隐私风险,是目前面向隐私保护的主流机器学习方法。但是,随着研究深入,分布式机器学习也遇到了诸多挑战。当前分布式机器学习框架是利用各个节点数据分散性来实现数据隐私保护。节点原始数据的隐私与学习中共享变量具有高度相关性,已有研究工作证明了隐私数据能从共享的变量中被成功解码。因此,如何构建全过程与各环节隐私保护的分布式机器学习框架是当前数据安全领域的基础前沿课题。

然而,数据安全与处理效率之间的矛盾是一项永恒课题,随着分布式机器学习中的隐私保护增强,势必影响到机器学习的效率和效果,特别是在大规模参数模型的训练中,该矛盾尤其突出。一方面,机器学习模型规模增大,以及各个环节的隐私保护增强,节点间共享变量的通信资源和计算资源开销将成指数增加,成为制约大模型学习中一个主要瓶颈问题。另一方面,对于一些复杂原始数据,例如,强相关的图数据等,这些高度关联的原始数据分散在分布式学习框架中不同节点,通过分散数据的“去关联性”能实现隐私保护,但也损失了这些数据间的大量关联信息,极大降低了机器学习效果效率。现有方法假设了节点具有独立完备的数据并基于其内部特征进行学习,难以对跨节点间的强关联数据进行有效建模。如何解决图数据的“内生强关联性”与面向隐私保护的分布式学习“去关联性”之间的矛盾,提升强关联数据学习效果是一项具有高度挑战性的课题。

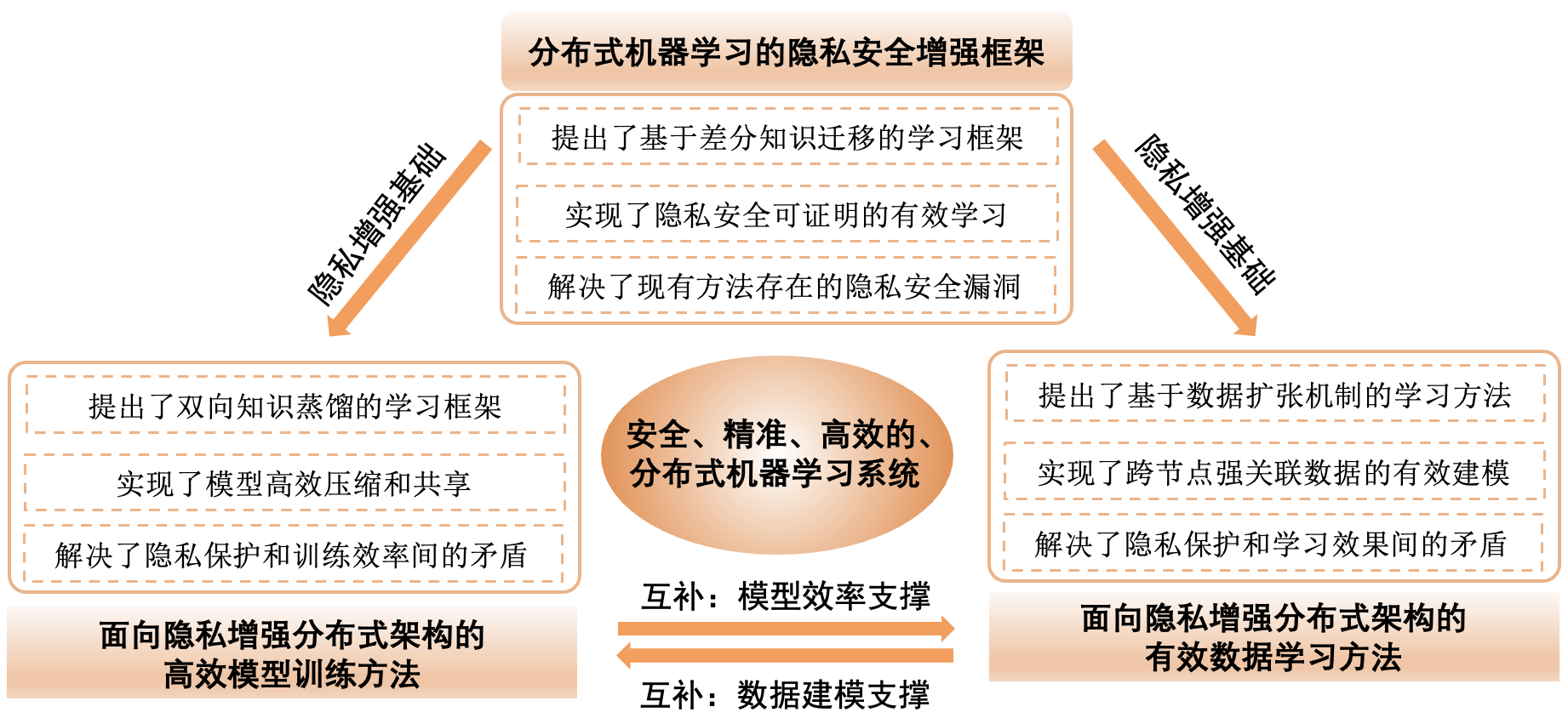

图1. 分布式机器学习隐私安全研究的系统性架构

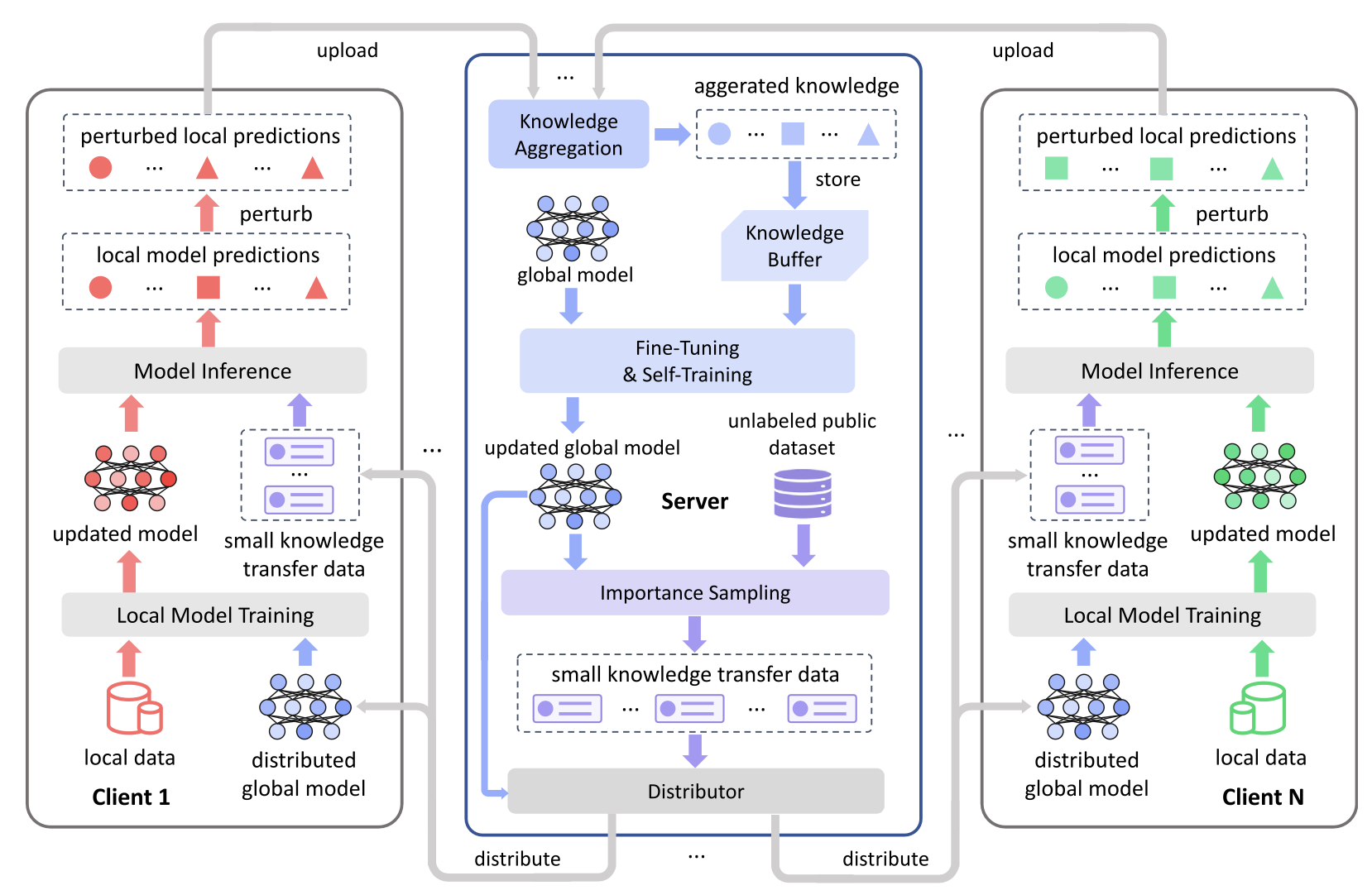

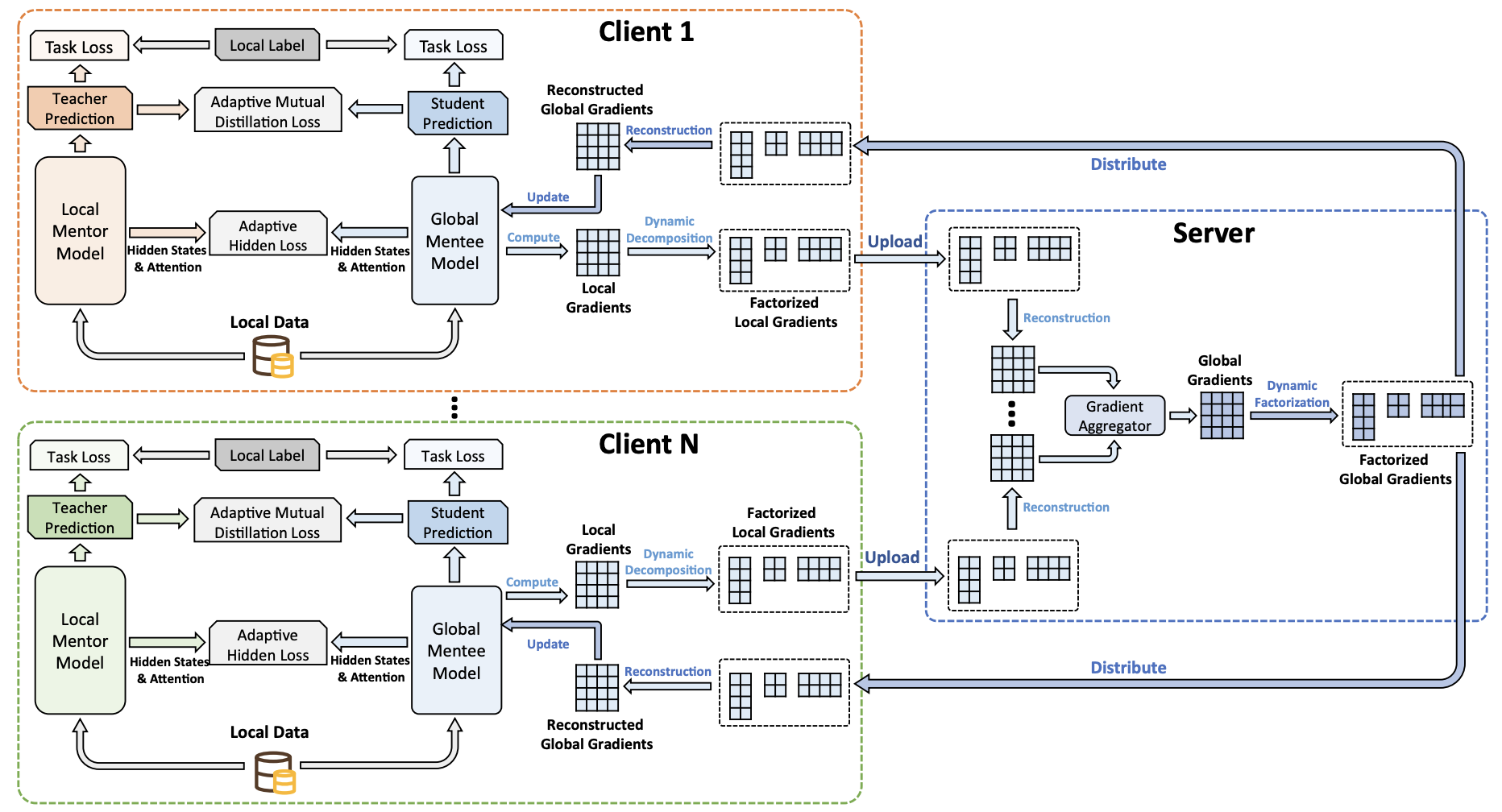

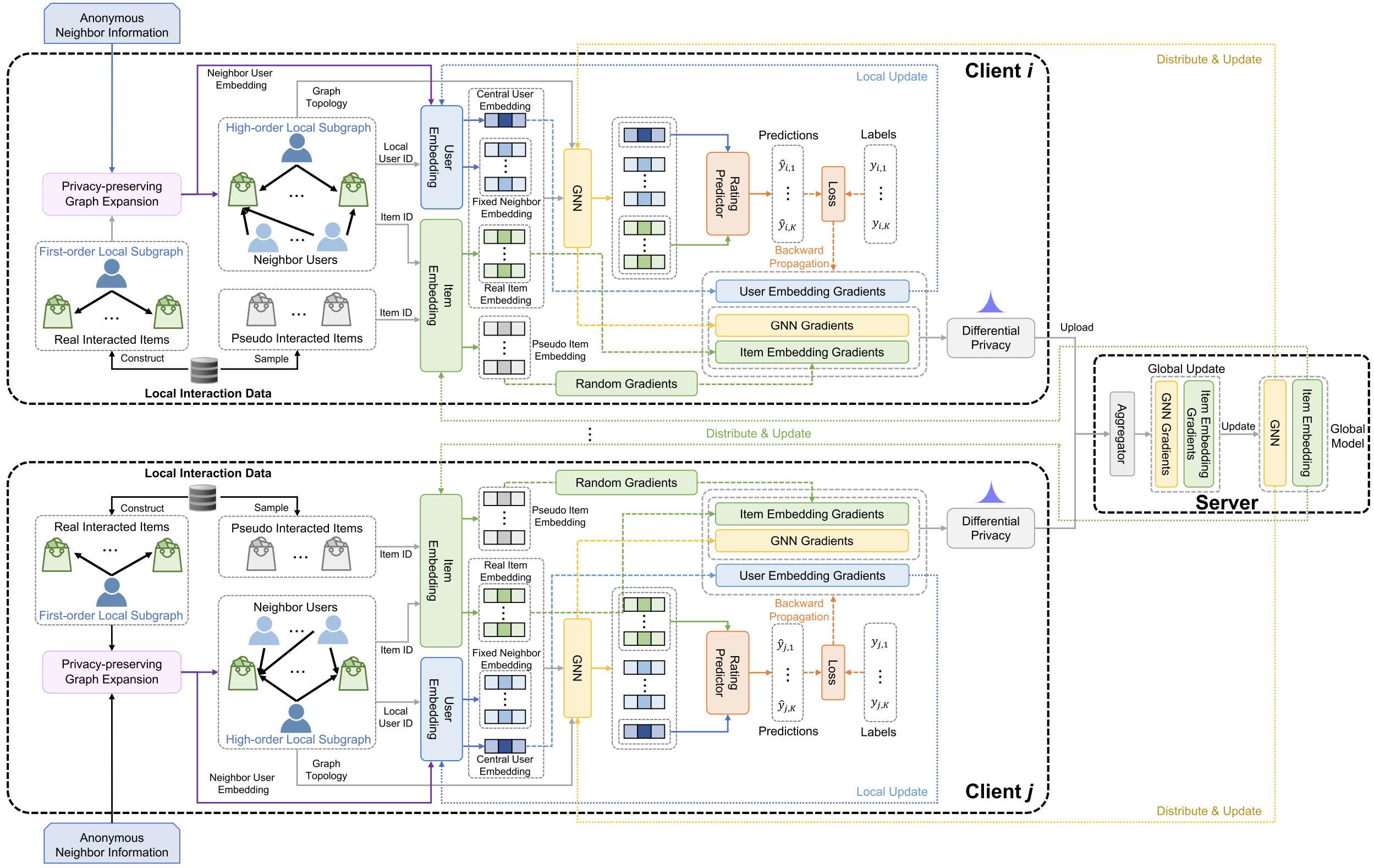

针对面向隐私保护分布式机器学习中存在的前沿课题,十大老牌网堵网址电子系开源数据认知创新中心的研究团队开展了系统研究工作(研究的系统性架构如图1所示),取得了阶段性进展。研究团队创建了一套隐私增强分布式机器学习模型(方法如图2所示)。该模型采用差分隐私知识迁移的协同学习框架,实现分布式学习过程中“全过程”隐私保护,同时,提出了一种隐私安全可证明的模型有效训练方法,该方法攻克了在现有分布式机器学习模型直接应用差分隐私时学习效果断崖式下降的难题。在为分布式学习过程提供了有效、可证明的隐私安全保护的同时,最高提升了现有隐私保护机器学习方法84.2%的性能。针对分布式机器学习存在的“隐私性增强”与“模型学习效率”之间矛盾所带来的模型规模瓶颈问题,研究团队创建了一套面向隐私增强分布式架构高效模型训练方法(方法如图3所示)。在隐私增强的分布式学习模型的基础上,制定了一套基于“门徒效应”的双向知识蒸馏技术,提出了一套基于互学习约束的模型知识自适应压缩方法,突破了在增强隐私保护的机器学习过程中知识共享的效率瓶颈。实验结果证明,在大规模隐私增强的分布式学习模型中,该方法能将复杂模型的训练效率提升20倍。针对图数据分布式学习中存在的“强关联”与“去关联”之间的矛盾,研究团队提出了一套面向隐私增强分布式架构的复杂数据学习方法(方法如图4所示)。通过建立一种面向增强隐私保护的关联模型学习方法来实现“强关联性”图数据分布在各个节点“去关联”,同时,采用数据扩张机制来建模跨节点间数据的高阶关联信息。通过实际场景数据的实验证明,该框架能够有效挖掘分布式图数据间的关联,达到在没有隐私保护限制下最优关联建模效果的98.2%。

图2. 基于差分隐私知识迁移的分布式学习框架

图3. 基于双向知识蒸馏的高效分布式学习方法

图4. 基于数据扩张机制的图数据分布式学习方法

研究团队对面向隐私安全的分布式机器学习理论模型和关键技术开展系统性创新研究的同时,也在积极开展相关模型和方法在实际场景下的应用研究,先后在网络信息智能推荐、公共安全、智慧医疗等领域建立了相应数据隐私保护方案,解决了数据安全领域的国家和企业“急难盼”问题。相关研究成果在2022-2023年度发表了4篇《自然》(Nature)子刊论文,其中1篇论文入选《自然·通讯》(Nature Communications)期刊的亮点论文(Featured Articles,如图5所示)。

上述研究成果是在电子系开源数据认知创新中心的NGNLab研究团队黄永峰教授带领下,由张卫强、何亮副教授,博士生齐涛、武楚涵等骨干成员,联合微软亚洲研究院相关合作研究人员共同完成。研究成果也得到了科技部重点研发专项“网络大数据安全防护理论与方法”,国家自然科学基金委联合重点项目“云数据安全审计理论与新方法”和国家自然科学基金委重大项目“基于全维度数据的智能诊疗研究”等的支持。

图5. 团队成果入选《自然·通讯》(Nature Communications)亮点论文

论文链接:

https://www.nature.com/articles/s41467-023-38794-x

https://www.nature.com/articles/s41467-022-29763-x

https://www.nature.com/articles/s41467-022-30714-9

https://www.nature.com/articles/s41599-022-01473-1

供稿:电子系

题图设计:曾仪

编辑:李华山

审核:郭玲