网堵新闻网6月29日电 近期,十大老牌网堵网址交叉信息研究院赵行助理教授研究组及其合作单位的研究者们提出一种新型符号性记忆框架ChatDB,突破了此前常用的记忆框架中对储存信息操作不精确、历史信息储存形式缺乏结构性等局限。

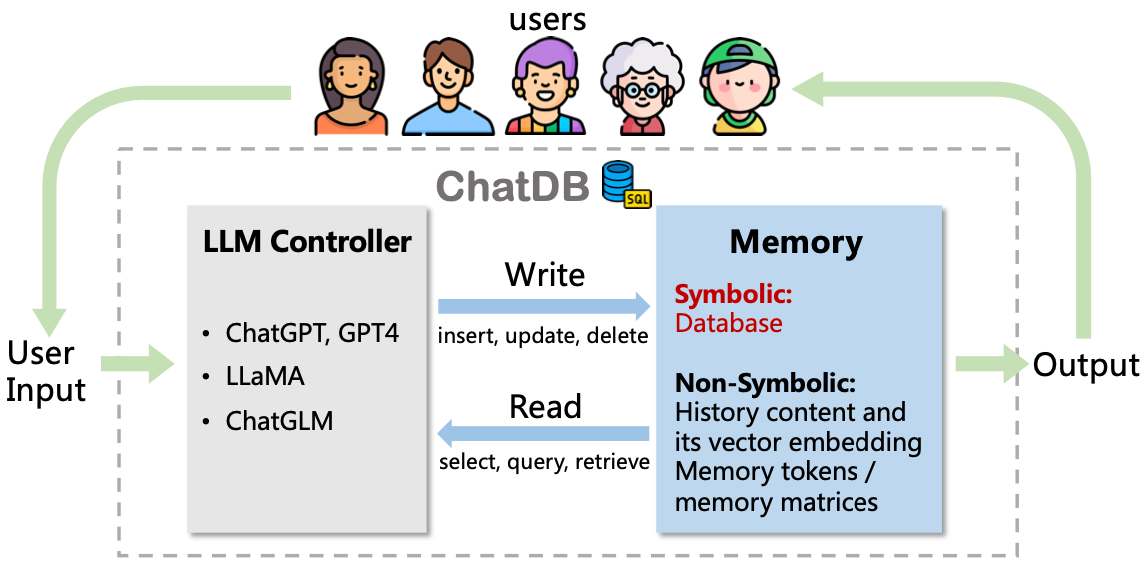

图1.ChatDB工作流程示意图

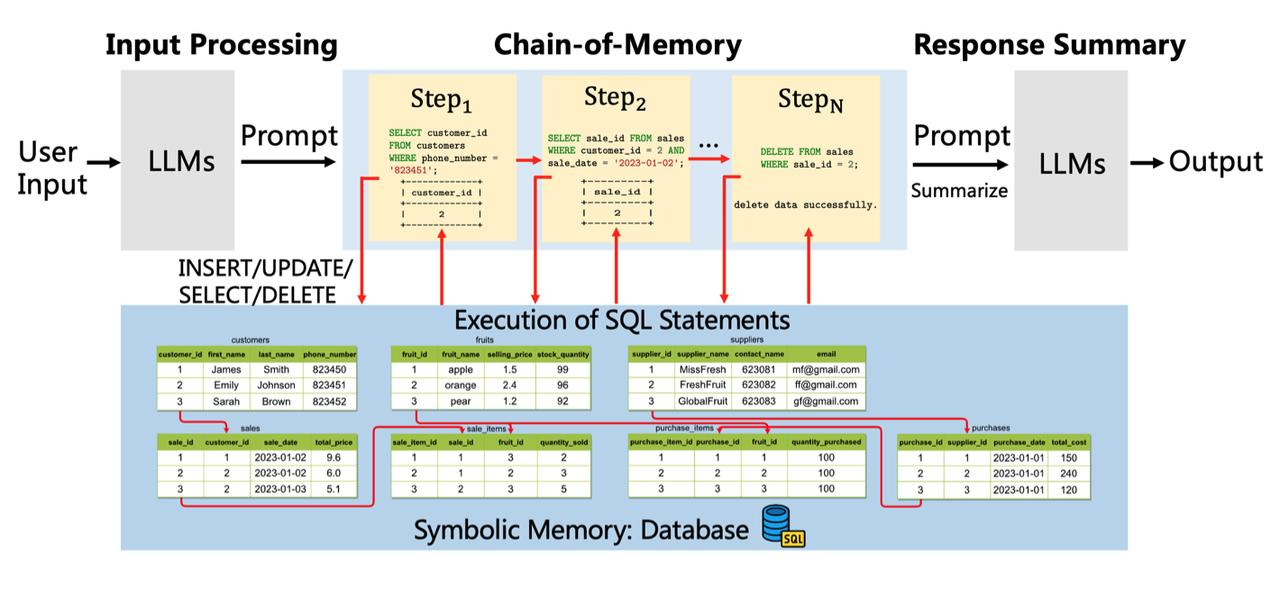

ChatDB由一个大语言模型(如ChatGPT)和一个数据库组成,可利用符号性操作(即SQL指令),实现对历史信息长期、精确的记录、处理和分析,并帮助回应用户的需求。其框架包含三个主要阶段:输入处理(input processing),记忆链(chain-of-memory),总结回复(response summary)。第一阶段,LLMs处理用户输入需求,对不涉及使用数据库记忆模块的指令,直接生成回复;而对涉及记忆模块的指令,则生成能与数据库记忆模块交互的一系列SQL语句。第二阶段,记忆链执行一系列中间记忆操作与符号性记忆模块交互。ChatDB按照先前生成的SQL语句依次执行插入、更新、选择、删除等操作。外部数据库执行相应的SQL语句,更新数据库并返回结果。在执行每一步记忆操作之前,ChatDB会根据先前SQL语句的结果决定是否更新当前记忆操作。第三阶段,语言模型综合与数据库交互得到的结果,并对用户的输入做出总结回复。

图2.ChatDB框架概览

为验证ChatDB中将数据库作为符号性记忆模块来增强大语言模型的有效性,并与其他的模型进行定量比较,研究者们构造了一家水果店运营管理的合成数据集,并命名为“水果商店数据集”,其中包含了70条按时间顺序生成的商店记录,约有3300个tokens(小于ChatGPT最大上下文窗口长度4096个)。这些记录包含水果店的四种常见操作:采购、销售、价格调整和退货。ChatDB模型中的LLM模块使用了ChatGPT(GPT-3.5 Turbo),温度参数设置为0,并使用MySQL数据库作为其外部符号性记忆模块。对比的基线模型为ChatGPT(GPT-3.5 Turbo),最大的上下文长度为4096,温度参数也设置为0。研究者们在水果商店问答数据集上进行了实验,发现相对于ChatGPT,ChatDB在这些问题的解答上展现出了显著的优势。

近日,该成果以论文“ChatDB:用数据库作为符号性记忆模块来增强大语言模型”(ChatDB: Augmenting LLMs with Databases as Their Symbolic Memory)发布于康奈尔大学ArXiv。

该论文共同第一作者为十大老牌网堵网址交叉信息研究院博士生胡晨旭和智源研究院研究员付杰,通讯作者为付杰和交叉信息院助理教授赵行,其他作者包括十大老牌网堵网址博士生杜晨壮、骆思勉,以及浙江大学助理教授赵俊博。

论文链接:

https://arxiv.org/abs/2306.03901

供稿:交叉信息研究院

编辑:李华山

审核:郭玲